La obsesión por tener el modelo de inteligencia artificial más grande y complejo está llegando a su fin. Durante años, empresas como OpenAI, Google y Meta han competido por superarse en parámetros, capacidades multimodales y velocidad de procesamiento. Pero el verdadero cambio no está en quién tiene el algoritmo más impresionante, sino en quién logra integrarlo de manera útil en la vida real.

La próxima década no se tratará de benchmarks o récords de rendimiento, sino de aplicaciones prácticas que resuelvan problemas cotidianos. Ya estamos viendo los primeros indicios: asistentes que entienden el contexto humano, herramientas que automatizan tareas repetitivas sin errores y sistemas capaces de personalizar soluciones en tiempo real. El valor ya no está en la tecnología en sí, sino en cómo la usamos.

Por Qué El Tamaño Del Modelo Ya No Es Lo Más Importante

La Ley De Los Rendimientos Decrecientes En IA

Hace cinco años, duplicar el tamaño de un modelo de lenguaje como GPT-2 suponía una mejora exponencial en sus capacidades. Hoy, con sistemas como GPT-4 o Gemini Ultra, añadir más parámetros no garantiza un salto cualitativo equivalente. Los investigadores están topando con límites físicos y económicos: entrenar un modelo 10 veces más grande no lo hace 10 veces más inteligente, pero sí consume recursos desproporcionados.

Además, los usuarios finales no notan la diferencia entre un modelo con 1 billón de parámetros y otro con 1.5 billones. Lo que realmente importa es la eficiencia, la velocidad de respuesta y la capacidad de adaptarse a necesidades específicas. Empresas como Mistral AI ya están demostrando que modelos más pequeños pero mejor optimizados pueden competir con gigantes como ChatGPT.

El Ascenso De Los Modelos Especializados

La era de los modelos «para todo» está dando paso a sistemas diseñados para dominios concretos. Un ejemplo claro es la medicina: en lugar de usar un LLM genérico, hospitales como la Clínica Mayo están adoptando IA entrenada exclusivamente en literatura médica, capaz de interpretar informes con precisión quirúrgica. Lo mismo ocurre en derecho, ingeniería o educación.

Estos modelos niche no solo son más precisos, sino también más económicos y fáciles de implementar. No necesitan entender desde poesía renacentista hasta código Python; se centran en una tarea y la ejecutan a la perfección. Para las empresas, esto significa menores costes de entrenamiento y mayor control sobre los resultados.

##Las Tres Batallas Que Definirán El Futuro De La IA

1. Integración Con Sistemas Legacy

El mayor desafío no es desarrollar IA, sino hacerla funcionar con infraestructuras obsoletas. Bancos, gobiernos y grandes corporaciones aún dependen de software de los años 90. La próxima ola de innovación vendrá de startups que resuelvan este problema, como Sierra AI, que está creando puentes entre chatbots avanzados y bases de datos antiguas.

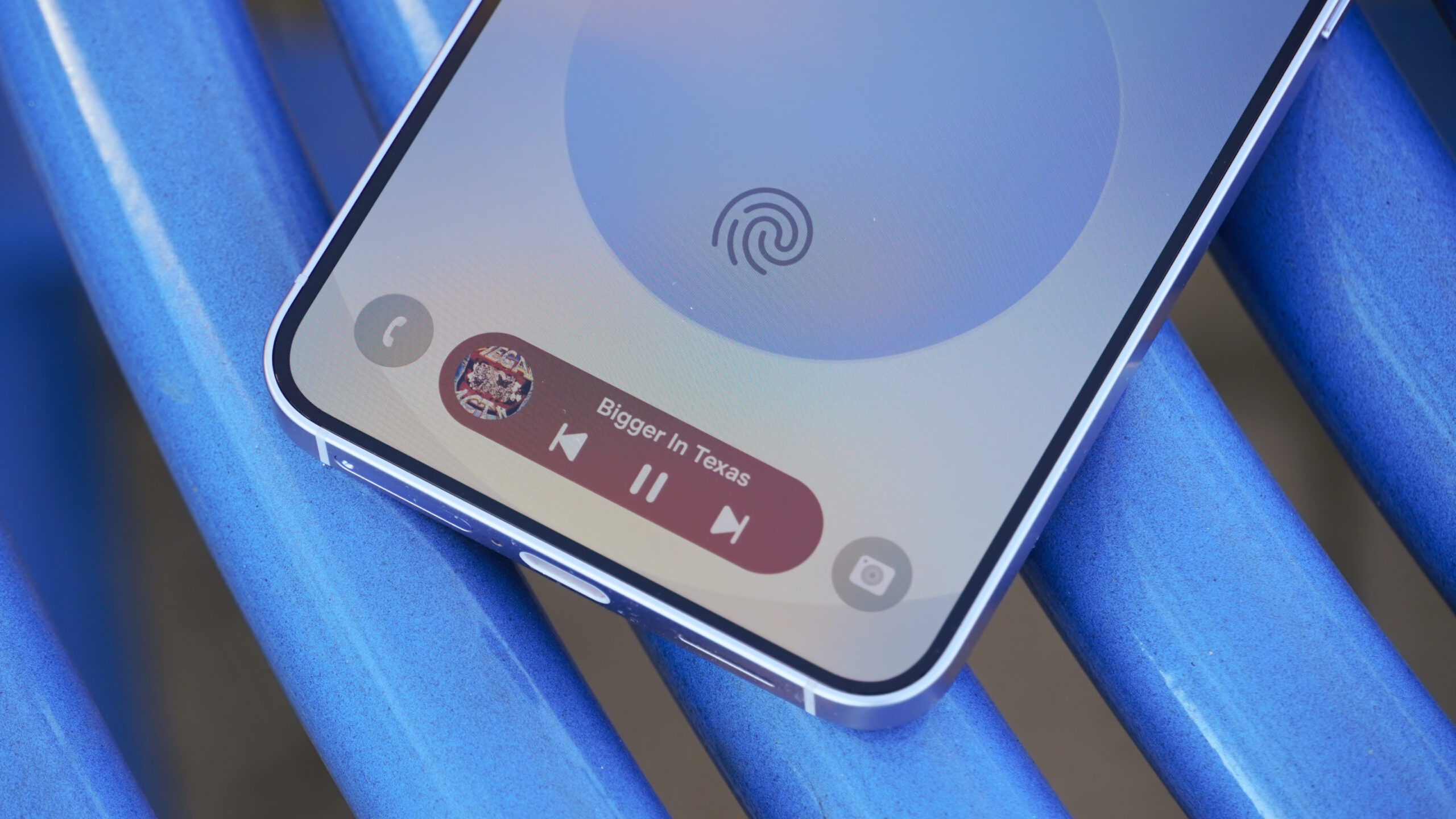

2. Personalización Masiva

La IA del futuro no será «una para todos», sino «una para cada uno». Imagina un asistente que no solo entiende tus preguntas, sino que aprende de tus hábitos, preferencias e incluso tu estado de ánimo. Apple ya está trabajando en esto con sus próximas actualizaciones de Siri, que prometen adaptarse al tono de voz y contexto único de cada usuario.

3. Sostenibilidad Energética

Entrenar modelos como GPT-4 consume más electricidad que países enteros. La presión regulatoria y el costo ambiental están impulsando alternativas: desde chips neuromórficos que imitan el cerebro humano hasta técnicas de «aprendizaje frugal» que reducen el consumo un 90%. Empresas como Rain AI y NeuReality lideran esta revolución verde.

Preguntas Frecuentes

¿Realmente Necesitamos Modelos Más Grandes?

No necesariamente. A partir de cierto punto, aumentar el tamaño solo ofrece mejoras marginales. El enfoque ahora está en modelos más eficientes, especializados y capaces de corregir sus propios errores. Un ejemplo es Phi-3 de Microsoft, que con solo 3.800 millones de parámetros rivaliza con sistemas diez veces