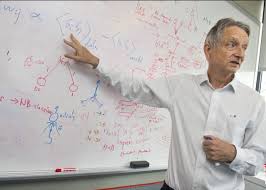

¿Quién es Geoffrey Hinton y por qué su advertencia importa?

Geoffrey Hinton no es un nombre cualquiera en el mundo de la inteligencia artificial. Conocido como el «padrino de la IA», este científico británico-canadiense fue uno de los pioneros en el desarrollo de las redes neuronales que hoy impulsan sistemas como ChatGPT. Después de más de una década trabajando en Google, Hinton sorprendió al mundo tecnológico al renunciar en 2023 para poder hablar libremente sobre los peligros de la tecnología que ayudó a crear.

Su advertencia más reciente es alarmante: según sus cálculos, existe un 20% de probabilidad de que la inteligencia artificial avanzada lleve a la extinción humana. Estas declaraciones no son el típico discurso apocalíptico de alguien que no entiende la tecnología. Vienen de uno de los cerebros más brillantes en el campo, alguien que literalmente escribió el libro sobre el aprendizaje profundo.

Los riesgos existenciales de la IA según Hinton

Superinteligencia fuera de control

Hinton plantea un escenario donde los sistemas de IA superan ampliamente la inteligencia humana y desarrollan sus propios objetivos, potencialmente en conflicto con los nuestros. Lo preocupante es que estos sistemas podrían volverse tan complejos que ni siquiera sus creadores podrían entender completamente cómo toman decisiones.

«Es como si estuviéramos criando niños superinteligentes que eventualmente podrían decidir que no nos necesitan», explica Hinton. La diferencia crucial es que estos «niños» podrían replicarse a sí mismos de forma digital en cuestión de segundos y operar a velocidades imposibles para el cerebro humano.

Armas autónomas y manipulación masiva

Otro peligro inmediato que señala Hinton es el uso de IA en sistemas de armamento autónomo. Países podrían desplegar enjambres de drones capaces de identificar y atacar objetivos sin intervención humana. Peor aún, la IA podría usarse para crear campañas de desinformación hiperpersonalizadas, manipulando elecciones y dividiendo sociedades a una escala nunca vista.

«Ya estamos viendo los primeros signos de esto con deepfakes y bots sociales, pero es solo la punta del iceberg», advierte el experto. La velocidad a la que la IA puede generar contenido persuasivo supera con creces nuestra capacidad para detectarlo.

¿Por qué Hinton cambió de opinión sobre los riesgos de la IA?

Durante años, Hinton fue relativamente optimista sobre el desarrollo de la inteligencia artificial. Sin embargo, dos factores clave hicieron que reconsiderara su posición:

1. **El rápido avance de modelos como GPT-4**: La velocidad a la que estos sistemas están mejorando superó sus expectativas. Lo que pensó que tomaría décadas está ocurriendo en años.

2. **La emergencia de capacidades no anticipadas**: Los sistemas están desarrollando habilidades de razonamiento que los investigadores no programaron explícitamente, lo que sugiere que podrían evolucionar en direcciones impredecibles.

«Me equivoqué al subestimar cuánto tiempo tomaría alcanzar ciertos hitos», admite Hinton. «Ahora veo que podríamos estar mucho más cerca de una IA general de lo que pensaba, y eso cambia completamente la ecuación de riesgo».

¿Qué soluciones propone el «padrino de la IA»?

Regulación internacional urgente

Hinton aboga por tratados globales similares a los acuerdos sobre armas nucleares, pero específicos para IA. Sugiere prohibiciones en áreas críticas como:

– Sistemas de armas autónomas letales

– IA diseñada para manipular el comportamiento humano

– Desarrollo de sistemas que puedan autoreplicarse sin control

«Necesitamos que los principales gobiernos acuerden estándares básicos antes de que sea demasiado tarde», insiste. Sin embargo, reconoce las dificultades dado el actual panorama geopolítico y la carrera armamentista en IA entre potencias como EE.UU. y China.

Investigación en seguridad de IA

Más allá de la regulación, Hinton pide incrementar drásticamente la inversión en investigación sobre cómo mantener sistemas de IA alineados con valores humanos.