La inteligencia artificial ha irrumpido con fuerza en el campo de la medicina, prometiendo revolucionar el diagnóstico y el tratamiento de enfermedades complejas como el cáncer. En particular, el análisis de muestras de tejido, conocido como histopatología, es un área donde los algoritmos de aprendizaje profundo han demostrado una precisión asombrosa para identificar patrones malignos que, a veces, escapan incluso al ojo humano más entrenado. Sin embargo, esta promesa tecnológica se ha topado con un obstáculo fundamental y profundamente humano: el **sesgo**. Los modelos de IA, al igual que los sistemas que los crean, pueden heredar y amplificar prejuicios presentes en los datos con los que son entrenados, lo que lleva a resultados menos precisos y, lo que es más preocupante, potencialmente inequitativos para ciertos grupos de pacientes.

Imagina por un momento que entrenas a un asistente virtual para reconocer rostros, pero solo le muestras fotografías de personas de una etnia específica. Es probable que ese asistente falle estrepitosamente al intentar identificar a alguien de un grupo demográfico diferente. Algo similar ocurre en la medicina computacional. Si un algoritmo para detectar cáncer de piel se entrena predominantemente con imágenes de piel clara, su eficacia se verá severamente comprometida en pacientes con tonos de piel más oscuros. Este no es un problema teórico; es un riesgo real que puede agravar las disparidades sanitarias existentes. Afortunadamente, la ciencia avanza para corregir estos desvíos. Recientemente, un equipo de investigadores ha desarrollado una **herramienta pionera** diseñada específicamente para identificar, cuantificar y, lo más importante, **mitigar el sesgo** en los modelos de IA aplicados al análisis de muestras cancerosas. Este desarrollo no es solo un paso técnico; es un imperativo ético para garantizar que la medicina del futuro sea precisa y justa para todos.

##El problema del sesgo en la IA médica: Más que un error técnico

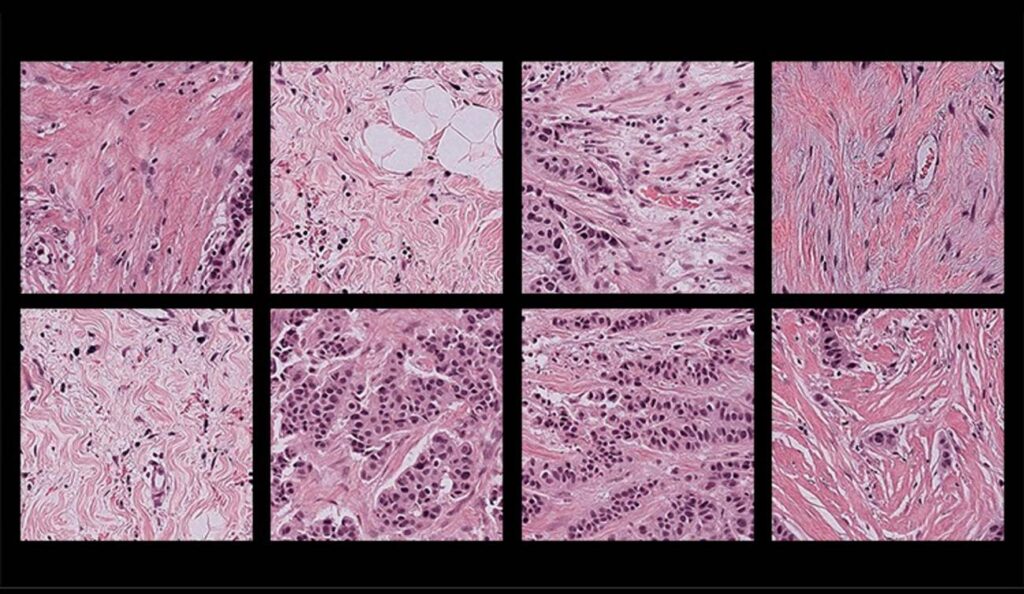

Para entender la magnitud del avance, primero debemos profundizar en la raíz del problema. Los modelos de inteligencia artificial, especialmente los basados en **aprendizaje profundo**, funcionan extrayendo patrones de enormes conjuntos de datos. En histopatología, estos datos son miles de imágenes digitalizadas de biopsias, cada una anotada por patólogos expertos que indican la presencia, el tipo y el grado del cáncer. El algoritmo «aprende» a correlacionar ciertos patrones visuales (la forma de las células, la estructura del tejido, las coloraciones) con un diagnóstico específico.

El sesgo se introduce en múltiples puntos de este proceso. El más evidente es la **composición de los datos de entrenamiento**. Si estos conjuntos de datos no son diversos y representativos de la población global en términos de etnia, género, edad o incluso de procedencia geográfica (que puede influir en las técnicas de preparación de las muestras), el modelo aprenderá un conocimiento parcial y sesgado. Por ejemplo, un estudio histórico puede haber reclutado principalmente a hombres de ascendencia europea, haciendo que sus hallazgos —y por extensión, los datos derivados— sean menos aplicables a mujeres o a personas de otras ascendencias.

Pero el problema va más allá de la demografía. Existen **sesgos técnicos** sutiles pero igualmente perniciosos. Las muestras de tejido pueden teñirse con diferentes protocolos en distintos hospitales o países, variando ligeramente su coloración. Un escáner puede producir imágenes con una resolución o un balance de luz diferente a otro. Un modelo entrenado con imágenes de un solo centro hospitalario, con sus equipos y protocolos específicos, puede fallar al analizar imágenes procedentes de otra institución. Este fenómeno, conocido como **»deriva del dominio»**, es una forma de sesgo que compromete la generalización y la utilidad real de la herramienta en el mundo clínico heterogéneo.

Las consecuencias de no abordar estos sesgos son graves. Pueden traducirse en **falsos negativos** (el algoritmo no detecta un cáncer en un paciente de un grupo subrepresentado) o **falsos positivos** (sugiere un cáncer donde no lo hay), lo que conduce a tratamientos innecesarios, ansiedad en el paciente y una pérdida de